L’AI spiegabile rappresenta una rivoluzione nella trasparenza dell’intelligenza artificiale, permettendo agli utenti di comprendere come i sistemi prendono decisioni. Questa tecnologia è essenziale per creare fiducia e garantire responsabilità nell’era dell’AI.

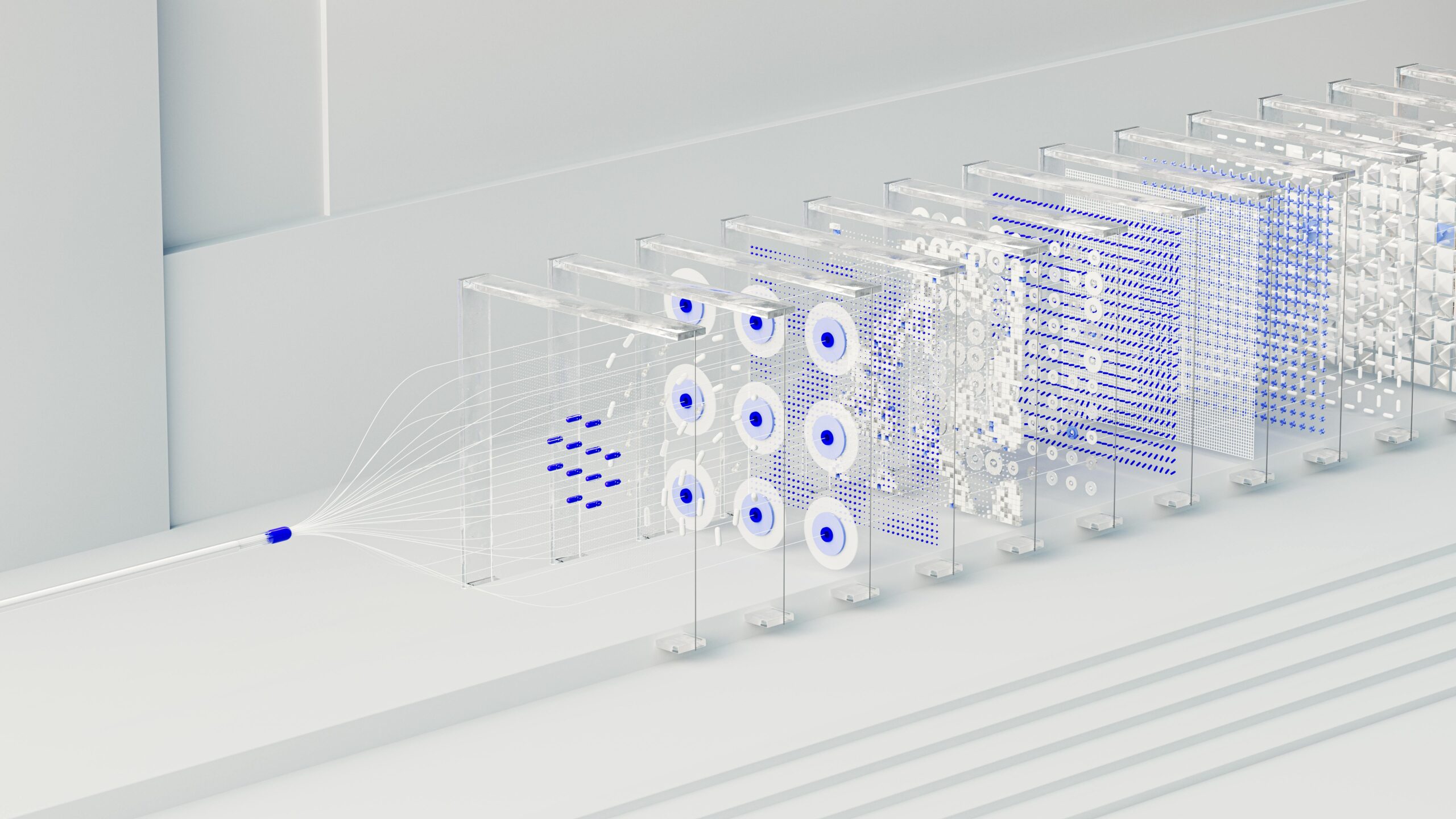

Nel mondo dell’intelligenza artificiale, una delle sfide più pressanti è la cosiddetta “black box” – sistemi AI che prendono decisioni senza che gli utenti possano comprendere il processo di ragionamento sottostante. L’AI spiegabile (Explainable AI o XAI) emerge come la soluzione a questo dilemma, promettendo di aprire la scatola nera e rendere trasparenti i meccanismi decisionali dell’intelligenza artificiale.

Cos’è l’AI Spiegabile

L’AI spiegabile si riferisce a metodi e tecniche nell’intelligenza artificiale che rendono i risultati della soluzione comprensibili agli esseri umani. A differenza dei modelli di machine learning tradizionali che operano come “scatole nere”, l’XAI fornisce spiegazioni chiare su come e perché un sistema AI ha raggiunto una particolare conclusione o raccomandazione.

Questa trasparenza non è solo una questione accademica: è diventata una necessità critica in settori dove le decisioni AI possono avere impatti significativi sulla vita delle persone, come medicina, finanza, giustizia e sicurezza.

Perché l’AI Spiegabile è Fondamentale

La necessità di AI spiegabile nasce da diversi fattori cruciali:

- Fiducia e adozione: Gli utenti sono più propensi ad accettare e utilizzare sistemi AI quando possono comprendere il loro funzionamento

- Conformità normativa: Regolamenti come il GDPR europeo richiedono il “diritto alla spiegazione” per decisioni automatizzate

- Bias e fairness: La trasparenza permette di identificare e correggere pregiudizi nei modelli AI

- Debugging e miglioramento: Comprendere i processi decisionali aiuta a ottimizzare le performances dei sistemi

Tecniche e Approcci dell’AI Spiegabile

Esistono diverse metodologie per rendere l’AI più interpretabile. Le tecniche LIME (Local Interpretable Model-agnostic Explanations) permettono di spiegare singole predizioni, mentre SHAP (SHapley Additive exPlanations) quantifica il contributo di ogni feature nel risultato finale.

Altri approcci includono l’attention mechanism nei modelli di deep learning, che mostra su quali parti dell’input il modello si concentra, e le decision trees interpretabili che visualizzano chiaramente il percorso decisionale.

Applicazioni Pratiche

Nel settore sanitario, l’AI spiegabile permette ai medici di comprendere perché un sistema ha diagnosticato una particolare condizione, aumentando la fiducia nelle raccomandazioni AI. In ambito finanziario, le banche possono spiegare ai clienti le ragioni dietro le decisioni sui prestiti, rispettando così i requisiti di trasparenza.

Nel campo della giustizia penale, l’XAI aiuta a garantire che i sistemi di valutazione del rischio non perpetuino bias discriminatori, fornendo spiegazioni chiare sui fattori considerati nelle valutazioni.

Sfide e Futuro

Nonostante i progressi, l’AI spiegabile affronta ancora sfide significative. Esiste spesso un trade-off tra accuratezza e interpretabilità: modelli più semplici sono più facili da spiegare ma possono essere meno precisi. Inoltre, diverse parti interessate possono richiedere diversi tipi di spiegazioni.

Il futuro dell’AI spiegabile punta verso soluzioni più sofisticate che mantengano alta accuratezza fornendo al contempo spiegazioni comprensibili. L’obiettivo è creare un’intelligenza artificiale che non solo performa bene, ma che possa anche giustificare le sue azioni in modo umano e accessibile.