L’AI interpretabile rappresenta una rivoluzione nel mondo dell’intelligenza artificiale, permettendo di comprendere il processo decisionale degli algoritmi. Questa tecnologia trasparente sta ridefinendo la fiducia tra uomo e macchina in settori critici come sanità, finanza e giustizia.

Nel panorama sempre più complesso dell’intelligenza artificiale, emerge una necessità fondamentale: comprendere come e perché i sistemi AI prendono determinate decisioni. L’AI interpretabile, anche nota come Explainable AI (XAI), rappresenta la risposta a questa esigenza cruciale, offrendo trasparenza in un mondo dominato da algoritmi sempre più sofisticati.

Cos’è l’AI Interpretabile?

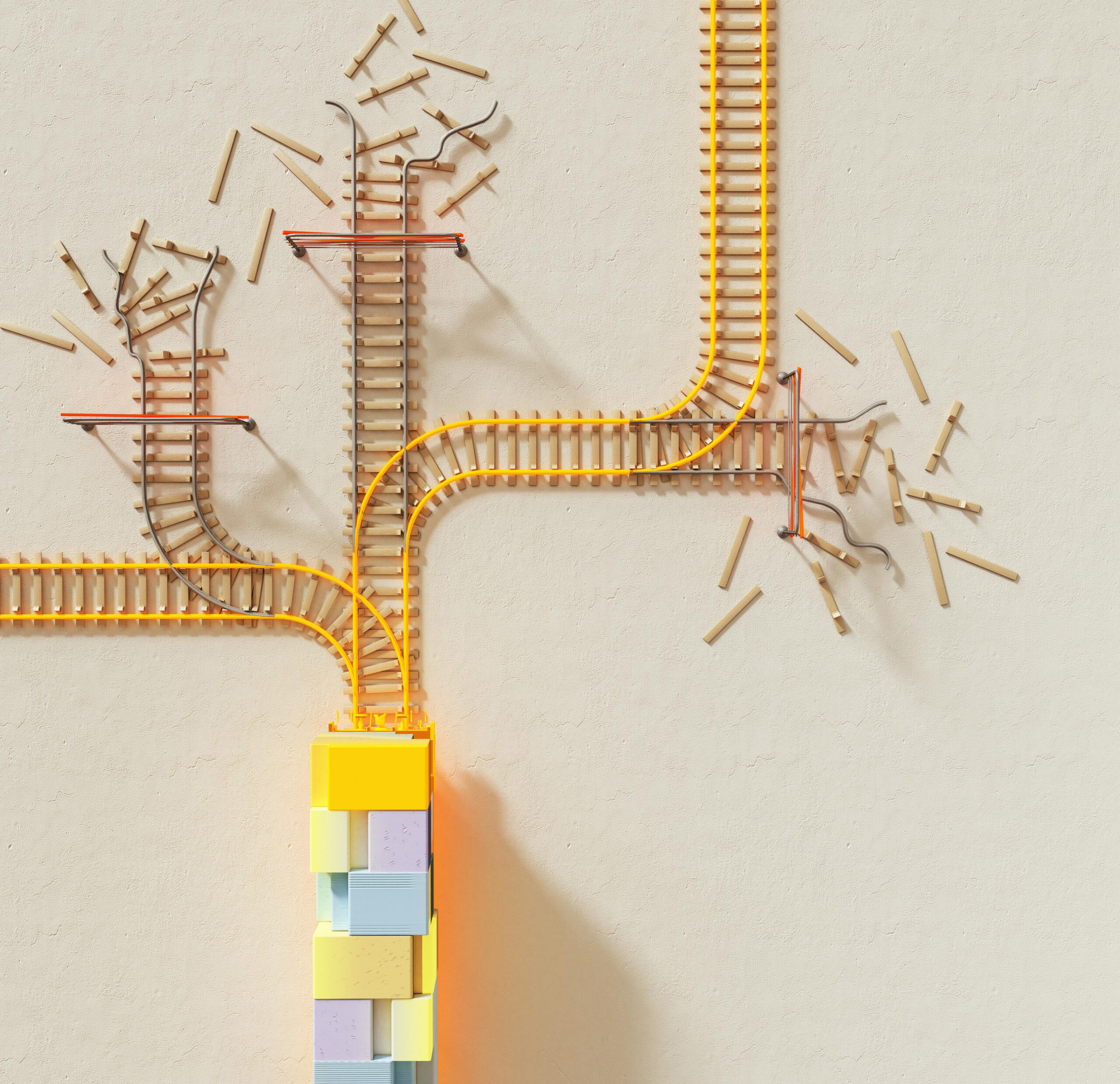

L’intelligenza artificiale interpretabile è una branca dell’AI che si concentra sulla creazione di modelli e sistemi in grado di spiegare le proprie decisioni in termini comprensibili agli esseri umani. A differenza delle tradizionali “black box” dell’apprendimento automatico, questi sistemi offrono una finestra trasparente sui loro processi decisionali.

Questa tecnologia non si limita semplicemente a fornire risultati, ma illustra il ragionamento che porta a tali conclusioni, utilizzando visualizzazioni, spiegazioni testuali e rappresentazioni intuitive che anche i non esperti possono comprendere.

Applicazioni Rivoluzionarie

L’impatto dell’AI interpretabile si estende across diversi settori critici:

- Sanità: I medici possono comprendere perché un sistema AI raccomanda una particolare diagnosi o trattamento, aumentando la fiducia e migliorando la qualità delle cure

- Settore finanziario: Le banche possono spiegare ai clienti i motivi dietro l’approvazione o il rifiuto di un prestito, garantendo trasparenza e conformità normativa

- Sistema giudiziario: Gli algoritmi di valutazione del rischio possono fornire spiegazioni chiare che supportano le decisioni legali

- Automotive: I veicoli autonomi possono spiegare le proprie decisioni di guida, aumentando l’accettazione pubblica

Sfide e Innovazioni

Lo sviluppo dell’AI interpretabile presenta sfide significative. Gli ingegneri devono bilanciare la precisione dei modelli con la loro interpretabilità, spesso trovandosi di fronte a un trade-off complesso. Tuttavia, le recente innovazioni stanno dimostrando che è possibile ottenere entrambe.

Tecniche come LIME (Local Interpretable Model-agnostic Explanations), SHAP (SHapley Additive exPlanations) e attention mechanisms stanno rivoluzionando il modo in cui interagiamo con l’AI, rendendo i sistemi più trasparenti e affidabili.

Il Futuro della Trasparenza AI

L’AI interpretabile non è solo una tendenza tecnologica, ma una necessità etica e legale. Con l’introduzione di regolamentazioni come il GDPR in Europa e l’AI Act, la capacità di spiegare le decisioni algoritmiche sta diventando un requisito fondamentale.

Guardando al futuro, possiamo aspettarci sistemi AI sempre più sofisticati che non solo performano eccellentemente, ma comunicano anche i loro processi decisionali in modo naturale e intuitivo, creando una vera partnership tra intelligenza umana e artificiale basata sulla comprensione reciproca.