L’etica nell’intelligenza artificiale è diventata prioritaria per sviluppatori e aziende. La creazione di sistemi AI trasparenti e responsabili richiede nuovi framework e metodologie per garantire equità e fiducia.

Con l’accelerazione dell’adozione dell’intelligenza artificiale in ogni settore, dal recruitment alla sanità, dalla finanza alla giustizia, la questione dell’etica nell’AI è diventata una priorità assoluta. Non si tratta più solo di creare sistemi efficaci, ma di garantire che siano giusti, trasparenti e responsabili.

La Sfida della Black Box

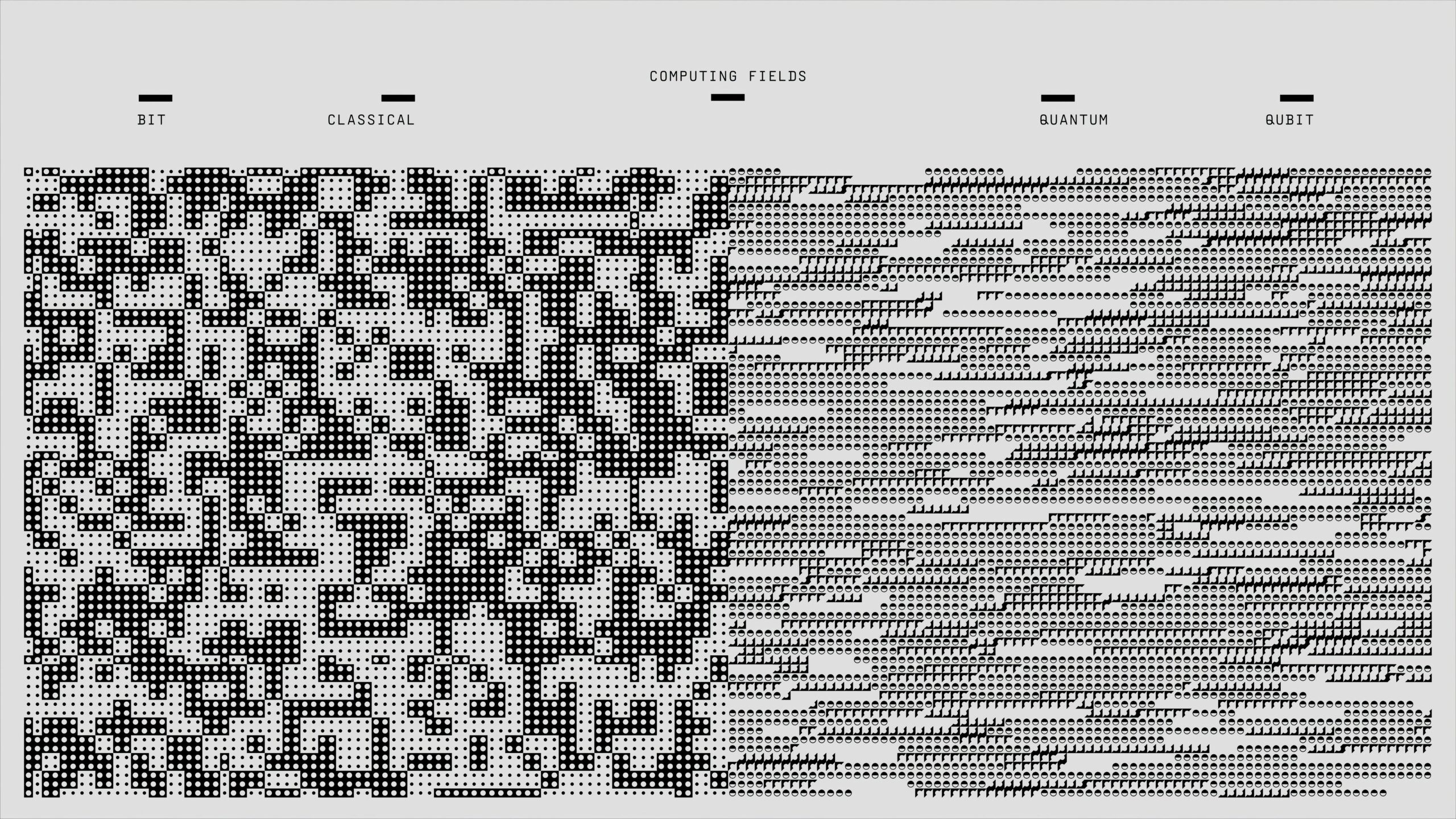

Uno dei problemi principali dell’AI moderna è la mancanza di trasparenza. I modelli di deep learning, seppur potenti, operano spesso come “scatole nere” di cui è difficile comprendere il processo decisionale interno. Questa opacità diventa problematica quando l’AI influenza decisioni cruciali come diagnosi mediche o approvazioni di prestiti.

Per affrontare questa sfida, sono stati sviluppati nuovi approcci come l’Explainable AI (XAI), che mira a rendere comprensibili le decisioni algoritmiche attraverso tecniche di visualizzazione e analisi delle caratteristiche più influenti nel processo decisionale.

Framework per l’AI Responsabile

Le principali tech company e organizzazioni internazionali stanno sviluppando framework etici strutturati. Questi includono principi fondamentali come:

- Fairness: garantire che l’AI non discrimini gruppi specifici

- Accountability: definire chiaramente le responsabilità umane nelle decisioni AI

- Transparency: rendere comprensibili i processi decisionali

- Privacy: proteggere i dati sensibili degli utenti

- Robustness: assicurare affidabilità e sicurezza del sistema

Strumenti Pratici per l’Implementazione

L’industria sta sviluppando strumenti concreti per implementare l’etica nell’AI. I bias testing tools permettono di identificare discriminazioni nei dataset e nei modelli. Gli audit algoritmici diventano pratica standard, mentre la documentazione dei modelli attraverso “model cards” garantisce trasparenza sulle capacità e limitazioni dei sistemi.

Inoltre, la diversità nei team di sviluppo si è rivelata fondamentale: team eterogenei sono più capaci di identificare potenziali bias e problemi etici durante lo sviluppo.

Il Futuro della Regolamentazione

L’Unione Europea ha fatto da apripista con l’AI Act, la prima legislazione completa sull’intelligenza artificiale. Questa normativa classifica i sistemi AI in base al rischio e impone requisiti specifici per la trasparenza e la sicurezza.

Il trend verso un’AI più etica e trasparente non è solo una questione morale, ma anche economica: la fiducia degli utenti è fondamentale per l’adozione diffusa delle tecnologie AI. Le aziende che investono in sistemi responsabili oggi costruiscono il vantaggio competitivo di domani.